Naoaki Okazaki

@chokkanorg

東京工業大学 情報理工学院 情報工学系 知能情報コース.自然言語処理・人工知能・機械学習の研究者.趣味プログラマ.

ID: 90111355

http://www.chokkan.org/ 15-11-2009 06:27:53

2,2K Tweet

7,7K Followers

781 Following

I’m at #ACL2025NLP to present our work on membership inference attack with Masahiro Kaneko , Yuki Wata and Naoaki Okazaki: 📄aclanthology.org/2025.findings-… 📍Hall 4/5, 16:00-17:30, July 29(Tues.) Looking forward to discussing with you!

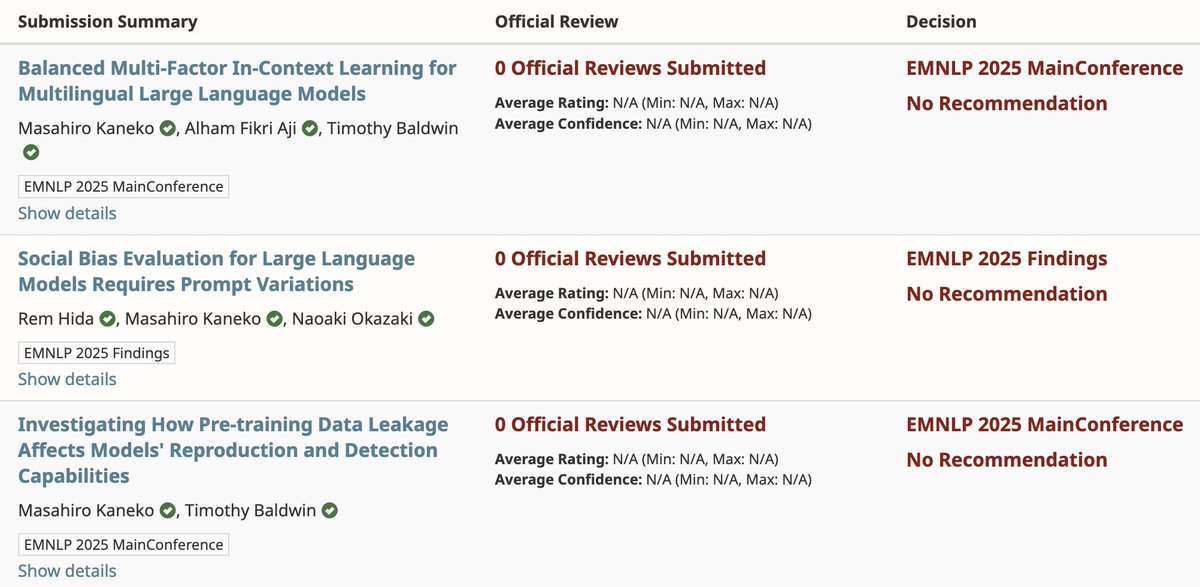

Two first-author long papers accepted to #EMNLP2025 main, and one co-authored long paper in Findings 🎉 Thanks Rem Hida, Alham Fikri Aji, Naoaki Okazaki, and Tim Baldwin! All on arXiv📜 - arxiv.org/abs/2502.11495 - arxiv.org/abs/2407.03129 - arxiv.org/abs/2403.16139