karminski-牙医

@karminski3

A coder, road bike rider, server fortune teller, electronic waste collector, co-founder of KCORES, ex-director at IllaSoft, KingsoftOffice, Juejin.

ID: 1071224721046261760

https://kcores.com 08-12-2018 02:07:30

2,2K Tweet

15,15K Followers

1,1K Following

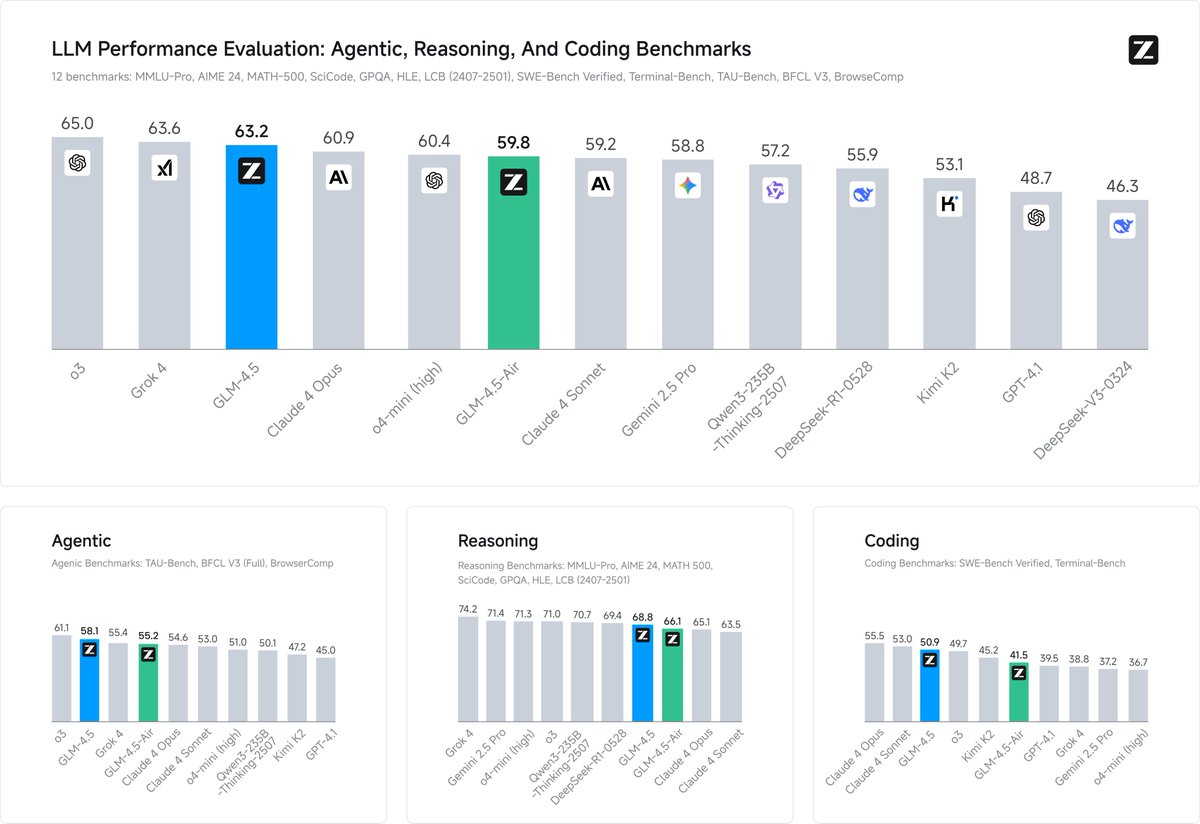

![karminski-牙医 (@karminski3) on Twitter photo LMArena 的 web 开发榜单 Qwen3-Coder 刷了个并列第一。

其实我觉得刷 web 开发其实是一个很好的方向,现在 web 比后端开发活跃很多,而且很直观能看到效果。专门推出一个面向web开发的模型都是值得的。接下来估计 GLM-4.5 也能挤进这个榜单。真的是国内开源模型盛况了[赢牛奶]

(图来自LMArena LMArena 的 web 开发榜单 Qwen3-Coder 刷了个并列第一。

其实我觉得刷 web 开发其实是一个很好的方向,现在 web 比后端开发活跃很多,而且很直观能看到效果。专门推出一个面向web开发的模型都是值得的。接下来估计 GLM-4.5 也能挤进这个榜单。真的是国内开源模型盛况了[赢牛奶]

(图来自LMArena](https://pbs.twimg.com/media/GxAPuURaYAAuxCY.jpg)